Verschleierungstaktiken und Irreführung bei den Hyperscalern Gesucht: Neue Metriken für die Nachhaltigkeit von Rechenzentren

Anbieter zum Thema

„Es gibt zwei große Nachhaltigkeitskomplexe, die die Rechenzentren und Cloud-Provider angehen müssen“, sagt Mark Butcher, Gründer des Beratungsunternehmens Posetiv Cloud: „Wasser- und Stromverbrauch.“ Es sieht eine dringende Notwendigkeit, Effizienz- und Nachhaltigkeitsmetriken zu überdenken. Dabei nimmt er sich auch die Hyperscaler zur Brust.

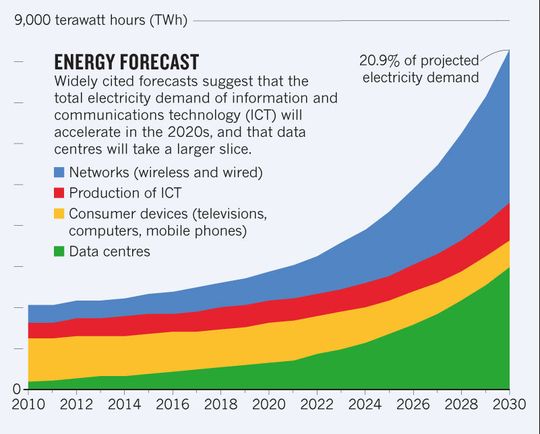

„Jedes große Rechenzentrum, ob privat, Co-Location oder Cloud, könnte seinen Stromverbrauch um 10 bis 40 Prozent senken“, schreibt Butcher unter anderem in einem Linkedin-Post. „Das entspräche vielen, vielen Terawatt-Stunden an Strom und Hunderten von Milliarden Gallonen Wasser.“ (siehe: Kasten)

Doch warum sollten sie das tun? Die Frage lässt sich relativ einfach beantworten: Die Zeit ist reif dafür, also der Markt:

„Nachhaltigkeit war in den vergangenen Jahren im Geschäftsleben so etwas wie flauschiger Unsinn, rekapituliert Butcher. CEOs und CFOs hätten ein ‚Net-Zero‘-Ziel deklariert, ohne jedoch ernsthafte Schritte zu unternehmen, dieses Ziel, zum Teil weit in die Zukunft verschoben, auch zu erreichen.

Jetzt gebe es nicht nur eine Reihe von Initiativen weltweit, etwa die von der Börse in Singapur, die Nachhaltigkeitsberichte fordere. Dann sei da der Green Deal in Europa und Bidens Nachhaltigkeits-Agenda in den USA, die EU-Energie-Effizienz-Richtlinie, die vermutlich gegen Ende dieses Jahres zu Gesetzen werde und von den Firmen Berichte auf unterschiedlichen Ebenen sowie Zeiträumen über die Nachhaltigkeit fordere. In Australien würden die Unternehmensleitungen gezwungen, aufzudecken, was ihre Company unternimmt, um gegen die Klimarisiken anzugehen. Nachhaltigkeit wird Bestandteil des Risiko-Managements.

Vor allem seit dem vergangenen Jahr werde auch Druck seitens der Investoren aufgebaut: Es gebe mehr Geld, wenn die zu finanzierenden Unternehmen nachhaltiger wirtschafteten, referiert Butcher, in Unternehmen, die ‚das Richtige‘ täten. Außerdem ständen die Chancen besser, das ‚richtige‘ Personal zu bekommen, wenn die Unternehmenspolitik stimme. Doch der größte Push käme von den Kunden und deren Kunden. Sie kauften bei Marken, die nachhaltiger wirtschafteten oder sich zumindest ihrer Verschwendung gewahr seien. Also: Egal wohin sich die CEOs, die CFOs sich auch wendeten, sie bekämen von jeder Seite Knüffe und Püffe.

Und dazu kommen die Energiepreise. Vor ein paar Jahren noch dürften die Energiepreise ungefähr 20 bis 35 Prozent der Gesamtkosten ausgemacht haben, die Datacenter-Kunden in die Ausstattung eines IT-Rack investieren mussten. Jetzt lägen die Kosten eher bei 80 bis 90 Prozent, vermutet Butcher. Es sei davon auszugehen, dass nicht alle Rechenzentrumsbetreiber ihre Energiekosten an ihre Kunden weitergeben könnten, was dem ein oder anderen durchaus das Geschäft gefährde.

Außerdem stiegen die Anforderungen pro Rack. In der Vergangenheit habe der Bedarf bei 3 bis 5 Kilowatt gelegen. „Kürzlich habe ich Anforderungen von 70 Kilowatt gesehen“. Das beeinflusst die Plattformkosten noch einmal mehr. Die Racks seien zum Teil nur halb gefüllt, weil die Datacenter-Betreiber nicht genügend Strom ins Rechenzentrum bekämen, um solche Racks zu betreiben. Das aber macht den Infrastrukturbetrieb umso ineffizienter.

Traditioneller Weise sei der PUE-Wert die maßgebliche Kennzahl gewesen, um die Rechenzentrumseffizienz zu messen. Allerdings habe es sich zumeist um eine Designgröße gehandelt, die weder die tatsächliche Auslastung noch den tatsächlichen Verbrauch wiedergegeben habe.

Nach Angaben des Uptime Institute arbeitet die Mehrheit der Rechenzentren (47 Prozent) mit einem PUE-Wert von 1,2 bis 1,5. Rund 38 Prozent liegen im Bereich von 1,5 bis 2,0 (siehe: Grafik von 2021). Doch PUE ist ein Instrument für die Facility-Abteilung des Rechenzentrums. Doch mit der Virtualisierung steigt unter Umständen die Auslastung im Rack, der Energiebedarf steigt und der PUE-Wert auch – ist also schlechter.

Angenommen ein Rechenzentrum geht von einer Eingangsleistung von 100 Kilowatt aus, wovon 50 kW für die Stromversorgung der IT-Geräte verwendet werden, käme es auf einen anfänglichen PUE-Wert von 2,0. Das Virtualisieren von ein paar Servern könnte vielleicht den Stromverbrauch der IT-Ausrüstung um 25 kW senken. Das beeinflusst den PUE-Wert aber nicht zwangsläufig positiv; denn jede Verringerung des IT-Bedarfs ohne entsprechende Verringerung der Kühllast führt zu einer höheren PUE.

Also: Wenn die IT-Last gesenkt wird, steigt die PUE immer an, was zu einer höheren PUE führt. Eine Erhöhung der IT-Last hingegen führt immer zu einer Senkung der PUE.

Um zu beurteilen, wie Energie-effizient ein Datacenter, ein Rack tatsächlich arbeitet, nutzt der PUE-Wert nichts. Es muss also beurteilt werden, was sich im Rack befindet, beziehungsweise was sich in der IT tut. Und auch das reiche nicht, wie Butcher ausführt. Schon allein durch unterschiedliche Auslastungsgrade könne der PUE doppelt so schlecht ausfallen wie im Design geplant.

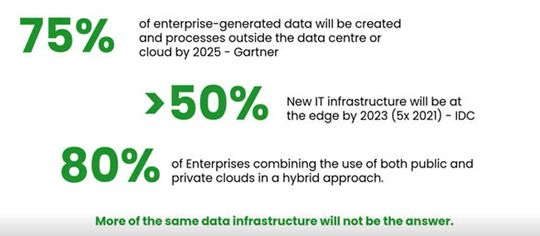

Zudem müsse die gesamte IT ins Visier genommen werden, zum Beispiel weil ein Großteil der Daten weder im Rechenzentrum generiert, noch verarbeitet werde (siehe: Abbildung).

Zum Beispiel sei Storage früher ein rein physikalisches Kapazitätsproblem gewesen. Drohten die Platten voll zu laufen, habe ein neues Device beschafft werden müssen. Heute müsste die IT entscheiden, was überhaupt bewahrt werden müsse, was auf welches Device gehöre, in die Cloud an die Edge.

Jetzt aber gebe es Cloud und in vielen Unternehmen eine Cloud-First-Strategie. Und hier trete ein kulturelles Problem zu Tage. Angesicht der gigantischen Vorteile, die Public Cloud mit sich gebracht habe, war es doch zunächst ein Problem limitierter Ressourcen – so die ursprüngliche Perspektive der Unternehmen.

Tatsächlich sieht das aber ganz anders aus: Die IT kontrolliert die Prozesse von der Cloud zur Edge und an dieser sind die Nutzer auf ‚Ergebnisse‘ fokussiert; sie interessiert nicht, was im Hintergrund passiert. Waren früher die Ressourcen an der Edge begrenzt, dann war es so. Jetzt wird auf die Public Cloud ausgelagert – zum Teil als gäbe es kein Morgen. Das sieht so aus, als sei es gut für das Business, doch tatsächlich geraten die Anwender ziemlich schnell in eine Preisspirale.

Was die Unternehmen eigentlich brauchten, sei ein kultureller Wandel bei dem nachgefragt und nachgewiesen werden müsse:

- Was wird tatsächlich benötigt?

- Warum wird was benötigt?

- Für welchen Zweck werden die Ressourcen gebraucht?

- Oder lässt sich eine Alternative finden, die die hybride Welt bietet? Sollten etwa die Daten näher an den Entstehungs- und Gebrauchsort statt in die Cloud?

Und hier spielt Nachhaltigkeit eine bedeutsame Rolle. „Spricht man mit den Leuten, vom Entwickler bis zum Chef, will jeder einzelne das Richtige tun – das Klima retten“, hält Butcher fest. „Aber sie haben Schwierigkeiten einzuordnen, das was sie tun, ihren kleinen Bestandteil im Zusammenspiel diverser Einflussfaktoren einzuordnen.“

Er pickt sich die Finanzseite heraus. „Jeder weiß, dass Public Clouds ein gutes Geschäft sind, dass die Betreiber riesige Gewinne machen und die Wachstumsgeschwindigkeit noch immer zunimmt. Dieses Jahr haben die Provider ihr Ziel von 500 Milliarden Dollar überschritten. Im nächsten Jahr werden es vielleicht eine Billion Dollar sein. Doch die Sache ist die, dass ein riesiger Anteil der Ausgaben, die in die Public Cloud fließen, für die Katz sind.“

Dieses Problem der Verschwendung kenne die Enterprise-IT, es sei ein generelles Effizienzproblem durch die Art und Weise, wie IT seit jeher geplant, gebaut und im Betrieb gemanaged werde. In der Public Cloud wäre es eigentlich sichtbar; denn diese lässt sich leicht an- und abschalten. Doch genau das passiere nicht. Im Gegenteil.

Denkfehler der Anwender

Die Unternehmen oder auch die einzelnen Abteilungen tendierten dazu, etwa die Instanzen zu überdimensionieren, sie auch in der Nacht zu nutzen, wenn sie gar nicht benötigt würden oder Zombie-Anwendungen laufen zu lassen. „Und in einer Public Cloud ist das ja so einfach. Die Anwender vergessen einfach, was sie ursprünglich bestellt und/oder installiert hatten.“

Aber auch Storage kommt bei ihm nicht besser weg. „Die Anwender essen Storage in der Public Cloud quasi zum Frühstück“, stellt er die Sorglosigkeit im Umgang mit IT- und damit mit Energieressourcen dar: zahlreiche Snapshots, endlose Backup-Kopien, falsches Tiering, zählt er auf.

Dazu komme Connectivity zwischen Plattform und den Services, Mikroservices und serverless functions – eigentlich die beste Art und Weise, effiziente Anwendungen zu bauen. Doch zumeist ist es das nicht und die Anwender haben Probleme mit dem Memory Sizing.

Schließlich kommt eine Angst hinzu, die so manch einer kennt, der bei der Bundeswehr war. Hier wurde zum Ende des Jahres Sprit mit Hilfe von Panzern und LKWs im Leerlauf verfeuert, um im darauffolgenden Jahr nicht weniger beschaffen zu können. Die Denke gibt es auch beim Ordnen von Cloud oder IaaS-Ressourcen (insbesondere bei Kunden der Öffentlichen Hand): Wenn ich in diesem Jahr mit weniger auskomme, bekomme ich in der nächsten Periode von der Unternehmensleistung womöglich kein größeres Budget genehmigt.

Die schöne neue Welt

Und dann gibt es einfach sehr viel Nachlässigkeit und Unbedachtheit: Ein Entwicklungsteam denke üblicherweise nicht darüber nach, welche Code-Library es unter Nachhaltigkeitsaspekten nutzen sollte, obwohl es welche gebe, die zehnmal mehr Energie benötigten als andere.

Potenzieren lasse sich alles auch noch durch einen höheren Automatisierungsgrad; denn die einmal getroffenen Entscheidungen werden nicht mehr in Frage gestellt. Butcher kommt so auf einen Verschwendungsgrad von durchschnittlich 35 bis 45 Prozent pro Unternehmen. Rechne man das um auf das Jahresaufkommen, werden bis zu 175 Milliarden quasi verbrannt. Trotzdem schlössen die Unternehmen Horrorverträge mit langer Laufzeit und einem Zuviel an allem - für einen vermeintlichen Discount-Preis.

Zugleich gaukelten ihnen die Provider eine schöne neue Welt, effizient und nachhaltig vor. „Hyperscaler sind großartig in ihrem Marketing“. Sie zeigten gerne, wie effizient ihre neuen Datacenter sind, wiesen ihre Investments in Erneuerbare Energien aus … alles schöne Dinge …. und sie demonstrierten den Kunden, wie sie großartige Plattformen bauen können, die auch noch umweltfreundlich sind.

Teilwahrheiten

„Ein Teil davon stimmt“, konstatiert Butcher. So sei die Tatsache, dass sie effiziente Services bieten könne, bequem für die Provider; denn das erhöhe ihre Margen. Und insofern passten hier Nachhaltigkeit und finanzielle Vorteile einmal gut zusammen und die Nutzer bekämen tatsächlich schlanke Prozesse.

Doch was die IT in den Unternehmen noch nicht begriffen habe, formuliert Butcher so: „Da kommt ein Sturm auf sie zu.“ Denn letztlich muss jeder Rechenschaft abgeben über die Entscheidungen, die zugunsten Umweltschutz oder vermeintlich anderer Ziele getroffen worden sind. die Frage:

„Wer ist [für diese Sauerei] verantwortlich“, werde zunehmend drängender und anklagender.

So müsse Nachhaltigkeit in jeder Abteilung, in jedem Prozess und jeder Aufgabe verankert werden. Das bedeute nicht unbedingt, dass jeder Teilbereich von der Software-Entwicklung, über den IT und Datacenter-Betrieb, bis zur Strategie und der Beschaffung nachhaltig sein müsse oder könne, aber Nachhaltigkeit gehöre in jede Entscheidung einbezogen, wie das auch für Security-Aspekte selbstverständlich sei.

Er gibt ein Beispiel: Es soll eine neue, große Anwendung entstehen und es steht die Frage an: Amazon in den Staaten oder in Schweden? Entscheidet sich das Unternehmen für AWS in den USA, könnte der CO2-Fußabdruck dreimal so tief sein, wie bei einer Entscheidung für eine schwedische Region. Wenn der Workload aber nach Schweden umzöge, lägen die Kosten unter Umständen 30 bis 40 Prozent höher. Die Frage lautet also: umweltfreundlich oder kostenbewusst?

Wilder Westen bei den Messgrößen

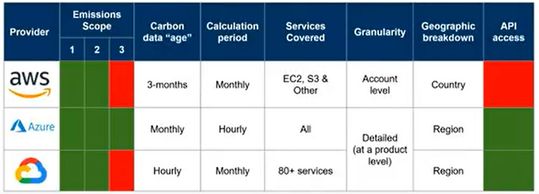

Selbst wenn Nachhaltigkeit in alle Entscheidungen sickerte, gäbe es keine verlässlichen Vergleichsgrößen. Butcher zählt auf.

- Die bisherigen Datacenter-Kennzahlen lassen etwa den Wasserverbrauch außen vor, und gelten zurecht als 'eindimesional'.

- Zudem gibt es ein gewaltiges Defizit an konsistenten Daten und schon gar keine verlässlichen Informationen, die den Fußabdruck in Echtzeit kennzeichnen.

- Zudem rechnen die IT-, Cloud-, Hosting-, Managed-Services- und Co-Location-Anbieter nicht alle Emissionen in die Kalkulationen ein, die sie der Öffentlichkeit zur Verfügung stellen.

So lassen die meisten Scope 3 aus, den größten Teil in einer Nachhaltigkeitsbilanz; denn hier bezieht die Nachhaltigkeitsbetrachtung die gesamte Lieferkette ein: von der physischen Infrastruktur eines Rechenzentrums, der Service, das Netzwerk, Switches, Storage .... bis hin zu Geschäftsreisen - alles in allem etwa 80 bis 85 Prozent der gesamten Emission.

- Außerdem gibt es kaum Modelle oder Tools, mit denen sich vergleichbare Aussagen treffen ließen. Hardware-Lieferanten geben den Anwendern lediglich 'Produktblätter' an die Hand, also statische Informationen, die sich weder anpassen noch überprüfen lassen.

- Auch fehlt es den Aussagen an Granularität.

Augenwischerei der Hyperscaler

Zum Beispiel (siehe: Tabelle) berechnet AWS seine Emissionen auf der Basis von Ländern, also aber nur für Scope 1 und 2. Außerdem setzt der Konzern ein Modell ein, das Durchschnittsangaben macht. Zudem verweisen sie auf Kompensationen und Erneuerbare Energien. Wenn demnach eines der AWS-Rechenzentren mithilfe regenerativer Energie funktioniert, kann das Unternehmen 'Null Emission' im Report über dieses Rechenzentrum ausweisen, obwohl Scope 3 ausgeschlossen ist und AWS gar nicht angeben kann, ob aktuell Wind und/oder Sonne das Datacenter befeuern, der Ausstoß also tatsächlich 1.000 Tonnen CO2 betragen könnte. Schließlich beträgt der Berichtszeitraum 3 Monate, die Daten sind also alt.

Im Vergleich dazu stände Microsoft schlecht da, weil das Unternehmen nach eigenen Aussagen 82 Prozent seiner Scope 3 einrechnet. Ferner basieren die Daten auf einer Monatsbetrachtung und stündlicher Berechnung und sind bezogen auf Regionen.

Google schließlich trifft CO2- Aussagen auf stündlicher Basis, kalkuliert für einen Monat und Produkt- und auf Regionen bezogen. Dabei bezieht Google 80 seiner Services ein, Microsoft alle und AWS einige, wie „S3“.

Fakt ist, dass die Cloud-Provider allesamt gut sind, ihre jüngsten, strahlendsten Projekte und Datacenter ins Rampenlicht zu stellen. Doch wollte man die Nachhaltigkeit eines Rechenzentrums tatsächlich beurteilen,müsste man genau hinschauen, um welches es sich handelt.

Tatsächlich gäben diese drei Hyperscaler viel für Nachhaltigkeit aus, aber sie ließen sich nur ungerne über die Schulter schauen, um zu verhindern, dass die alten, hässlichen Rechenzentren für einen Großteil ihres Profits sorgen, erläutert Butcher; denn die neuen seien noch gar nicht voll. Es gelte zu verhindern, dass die Kundschaft womöglich von einem unsauberen in ein anderes umzögen oder von einer Region in eine andere.

:quality(80)/p7i.vogel.de/wcms/ea/f6/eaf6ecd505df9ddfbf88fe3508310132/0106438752.jpeg)

Energie-KPIs messen, verstehen und öffentlich machen

SDIA fordert radikale Transparenz und Innovation in der digitalen Infrastruktur

Die schlechtesten Transparenznoten vergibt Butcher allerdings an die Cloud-Provider IBM und Oracle. Hier gäbe es überhaupt keine detaillierteren Einsichten, lediglich Klugscheißer-Anweisungen, wie man sich den CO2 berechnen könne - „reiner Müll“.

Allerdings betrieben diese Firmen nahezu eine Gelddruckmaschine: Wenn man die 500 Milliarden Dollar Umsatz in diesem Jahr nähme und einem durchschnittlichen Profit von 35 Prozent ansetze, kämen die Konzerne auf einen Verdienst von 165 bis 170 Milliarden Dollar. Die Frage könne demnach nicht sein, ob diese Unternehmen in Nachhaltigkeit investieren könnten, sondern ob es für sie profitabel genug erscheine.

Anm. der Redaktion: Die Aussagen von Mark Butscher wurden im Wesentlichen dem Brighttalk-Webinar „Rethinking The Metrics of Sustainable & Energy Efficient Data Infrastructure“ entnommen.

Artikelfiles und Artikellinks

(ID:48556696)

:quality(80)/p7i.vogel.de/wcms/1f/12/1f1260c3df0416fff1a03a19f08196c6/0117767227.jpeg)

:quality(80)/p7i.vogel.de/wcms/a1/24/a124958664ef71b8c56b440c49f03e63/0117709843.jpeg)

:quality(80)/p7i.vogel.de/wcms/51/45/51455ce52308a1b03f7e95e9696c7df8/0117667712.jpeg)

:quality(80)/p7i.vogel.de/wcms/bf/7f/bf7f6709215e7167326e0b4cfea3fa7d/0117669491.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/76/3c76ff98bfd85ae130b79c948640fc1f/0117821493.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/f7/0ff7e8a006f5d87fcf6460a6ed02587c/0117793673.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/04/7a04fa3d86ff0e304f68f044e8ececfc/0117780015.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/2c/9f2cd9daf29a929f15c5cd0b26da673b/0117848608.jpeg)

:quality(80)/p7i.vogel.de/wcms/24/fc/24fc357d4ed8f5c6500da52c0f5b2dec/0117727355.jpeg)

:quality(80)/p7i.vogel.de/wcms/02/f3/02f3b02239ac228d4c24f9812dffd6c3/0117866623.jpeg)

:quality(80)/p7i.vogel.de/wcms/4b/9e/4b9ef0b509dc376675682d114ae41a96/0117793805.jpeg)

:quality(80)/p7i.vogel.de/wcms/9f/cf/9fcf8a5268ff444c71d5ec5b91956f04/0117816823.jpeg)

:quality(80)/p7i.vogel.de/wcms/dd/4b/dd4b966903663a25da9a563a503bdca5/0117806385.jpeg)

:quality(80)/p7i.vogel.de/wcms/9e/e0/9ee04bdec5d842254716a56d956ff358/0117572577.jpeg)

:quality(80)/p7i.vogel.de/wcms/e4/1c/e41ccb215fd0aad7b9ab0f66bddf0c2c/0117564858.jpeg)

:quality(80)/p7i.vogel.de/wcms/0c/29/0c29cfdef0bef45d969595cf6aeb4cb7/0117284743.jpeg)

:quality(80)/p7i.vogel.de/wcms/24/9f/249fd68b693a656acd9cfecd5789a9cf/0117284710.jpeg)

:quality(80)/p7i.vogel.de/wcms/29/1e/291ed2b23f87bb349f2e14fd08e5985a/0117197907.jpeg)

:quality(80)/p7i.vogel.de/wcms/4a/ad/4aadd3fc22bbb69cd340c8930587e6c5/0117792616.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/e4/7ae40ab0ad814a3438200e2e0565d19c/0117538366.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/32/5b32471b2fc5eed796e6337de9617610/0117166583.jpeg)

:quality(80)/p7i.vogel.de/wcms/ab/63/ab636d1161af20016512f5db1398a5a5/0117903018.jpeg)

:quality(80)/p7i.vogel.de/wcms/2d/3d/2d3d14768c1ccc56c267d1b0005b6aa9/0117870937.jpeg)

:quality(80)/p7i.vogel.de/wcms/5b/90/5b9077c213fc5cc0e999093e1b690e3a/0117206477.jpeg)

:quality(80)/p7i.vogel.de/wcms/c4/c4/c4c4a34b823f39aac9b2a41f45d2763a/0117007080.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/bb/c9bb7c0af3ca2b340fa094de1f895078/0116812287.jpeg)

:quality(80)/p7i.vogel.de/wcms/72/d4/72d4e133d879bff354491edfe00c2262/0116767655.jpeg)

:quality(80)/p7i.vogel.de/wcms/bb/80/bb80be0c5bd76440174fa8736c0fc68a/0109079523.jpeg)

:quality(80)/p7i.vogel.de/wcms/90/40/904072c10c6cfb25aa589ccdc2b731a0/0105957803.jpeg)

:quality(80)/p7i.vogel.de/wcms/28/91/2891191f43d783185e01b7838e3ae6cd/0105726161.jpeg)

:quality(80)/p7i.vogel.de/wcms/53/46/5346a50e5bca503a89be890d8ccafb2f/0105679922.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/da/f3dacd38e5834ae3f3c9d0a4bc9664d3/0113348475.jpeg)

:quality(80)/p7i.vogel.de/wcms/90/f5/90f56ec6cb3ddbdabca2162fd5477836/0113078524.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/09/0f097990002b7600075e43c92af4a3fd/0110524571.jpeg)

:quality(80)/p7i.vogel.de/wcms/66/ae/66ae9e32738784b57e2ad8c1a4b0986f/0109756744.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/1b/ff1bf13207bfcba03383fbeb30a3c5c6/0117931452.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/8a/c28a3e2b1e5a668e85a60ab1513f0505/0114961639.jpeg)

:quality(80)/p7i.vogel.de/wcms/51/6b/516b6a7be304ba9862e972c6e11c9fec/0114109625.jpeg)

:quality(80)/p7i.vogel.de/wcms/e3/09/e3096d6dce558738c51c5ca878041061/0107846251.jpeg)

:quality(80)/p7i.vogel.de/wcms/d0/4e/d04ed61cedb2e95dd4239fe7dc09da1c/0107796204.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/60/87/6087e22313077/fujitsu-300dpi--002-.jpg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/57100/57113/65.jpg)

:fill(fff,0)/p7i.vogel.de/companies/64/f1/64f18cf620acb/stackit-logo.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/cc/69cc870a79b0fc5569c23fc533f87e88/0115492438.jpeg)

:quality(80)/p7i.vogel.de/wcms/28/9d/289d06012cc7567d00e038c823014192/0115739536.jpeg)